Cuenta la leyenda que hasta 1697 el mundo occidental creía que todos los cisnes eran blancos.

Ese año llegarían los holandeses a Australia, donde se encontrarían con los primeros cisnes negros que ellos habían visto.

Por supuesto, para los australianos no había ninguna sorpresa, pero para el resto del mundo sí.

Este evento ha sido utilizado por Nassim Taleb (nuevamente, los principios filosóficos triunfan sobre “la evidencia”) para acuñar un evento matemático inherente a todo tipo de sistemas:

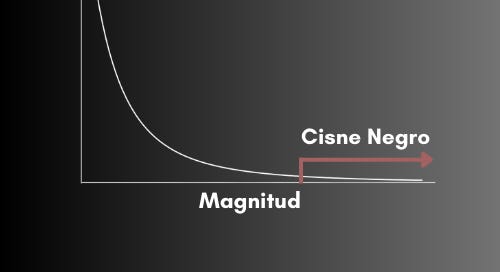

Los eventos impredeciblemente impredecibles o Cisne Negro.

Son eventos raros (poco frecuentes), que tienen un gran impacto (valro o magnitud alta).

Estos eventos pueden ocurrir en cualquier momento, y por su naturaleza impredecible y de gran magnitud son los eventos que realmente modifican el status quo.

La teoría del meteorito que habría desencadenado la extinción de los dinosaurios; la explosión de volcanes como en Pompeya; las caídas del mercado durante el 2008 y el 2015; la aparición del Covid-19 a fines del 2019.

La mayor parte del planeta no vio venir estos eventos.

Sin embargo, al igual que los cisnes, los eventos Cisne Negro son evidentes para un lado de la ecuación.

Por ejemplo, si alguien iba montando el meteorito en su viaje espacial la fecha y hora de su colisión eran perfectamente calculables.

Para quienes entendían de las burbujas inflacionarias la aparición de una caída brusca no era sorpresa. La dificultad yace en que al tratarse de un sistema complejo, no era predecible el día de la caída, sólo que esta ocurriría.

Con el Covid la historia es similar. Si aceptamos la explicación más probable: que se escapó de un laboratorio en China; entonces quienes estaban trabajando en dicho laboratorio, junto con las primeras personas que trataron de encubrirlo sabían de la posibilidad de una pandemia, sólo que le resto de nosotros nos enteramos mucho después.

Otro ejemplo de esto es el ataque a las Torres Gemelas en el 2001.

Para los terroristas el desenlace estaba claro, pero la gente en las torres era ciega a esta posibilidad.

Y el ejemplo más claro—y el mismo que usa Taleb en su libro—es el del pavo de Acción de Gracias, que para el mundo hispano sería como el pavo de Navidad.

Contexto:

Una de las ideas que mueve la nueva Era de la Información está basada en el supuesto que podemos predecir el futuro.

Se trata del intento de determinar qué va a pasar basado en los eventos previos.

Es la reducción de lo complejo a lo complicado (escribí de esto aquí). El tratar de plasmar lo que es por definición infinito en un gráfico Gaussiano.

Es la razón por la que seguimos teniendo caídas cíclicas del mercado; por qué los errores médicos son una de las principales causas de muerte; y por qué los burócratas proliferan como la maleza.

Las proyecciones del mercado caen en la misma categoría.

El problema del pavo de Navidad:

Un politipavo decide hacer una presentación para su ciudadanía: en ella decide proyectar el futuro del bienestar pavuno—basado en alimento provisto y aumento de tamaño—y esto lo hace el día antes de Navidad (o Accion de Gracias en EE.UU).

En su gráfico—que se vería como cualquier clásica proyección de mercado tipo Fintual—muestra una bonita curva, muchas veces exponencial, que proyectaría un máximo y un mínimo esperado de bienestar de tipo exponencial.

Por supuesto, el día del matadero esta proyección pasa directamente a cero, pero ellos no lo sabem.

Es más, el día antes del matadero es el día donde la proyección se vería más positiva.

Y el politipavo, como es “inteligente” decidiría que se trata del momento perfecto para presentarlo mientras anuncia su candidatura a reelección.

Todos muertos al día siguiente.

Resulta que eran ciegos a la Navidad, y por lo tanto a convertirse en el plato principal de una buena parte de la población.

El problema del pavo de Navidad nos enseña que mientras más utilizó la información de los eventos pasados en una proyección sobre un sistema complejo, más lejana a la realidad se vuelve ésta.

En otras palabras:

Mientras más información tiene una predicción reduccionista, más equivocada está la proyección.

La sorpresa del matadero es máxima mientras más politipavos y buropavos deciden convencerte de que votes por ellos.

En la contracara de la moneda, quien los está engordando sabe desde un principio cuál es la fecha en que van a ser faenados, si a él el consejo pavuno le muestra el gráfico le parecería de lo más chistoso.

En el fondo es sólo un problema de información parcial, algo simple de resolver con más y mejor información.

¿O no?

Los sistemas complejos contienen por definición información infinita. Siempre existirá el problema de la información parcial.

No sirve sólo agregar información, porque si esta nos ciega a los eventos Cisne Negro (nos convence de que podemos hacer proyecciones), se maximizan los errores. Termina siendo contraproducente.

¿Qué hacer?

A Favor de la Neofobia

Si vivimos en un mundo de información infinita, y por lo tanto siempre parcial; debemos buscar principios para la toma de decisiones.

Estos principios deben tratar de agregar información que haya sobrevivido en el tiempo.

Lo que se denomina el Efecto Lindy: aquello que ha sobrevivido en el tiempo tiene más probabilidad de sobrevivir más tiempo.

Es la razón por la que la música clásica seguirá siendo escuchada en 200 años, y nadie recordará a tu reaggetonero famoso actual (quizás Franco el Gorila se salve, que crack).

O por qué la gente religiosa vive más que la gente no religiosa, más allá de las explicaciones “racionales” hay conocimiento empírico que aunque no lo podamos explicar funciona.

O por qué el Señor de los Anillos va a ser siempre la mejor triología de la historia del cine… En realidad esta no tiene nada que ver, pero se la peleo a cualquiera.

…

El efecto Lindy es una explicación matemática para la neofobia: aquella tecnología revolucionaria que promete salvar vidas, ser “segura y efectiva” y especialmente si promete ser sólo positiva; de esa hay que escapar a perderse.

Es al mismo tiempo una explicación para las posturas más conservadoras: aquello que ha probado funcionar es esperable que continúe funcionando, incluso si el panorama parece ser distinto—especialmente si hay econopavos, politipavos y buropavos tratando de convencerte de algo que choca con la evolución o tu observación juiciosa de la realidad—

Por supuesto sin renovación todo se corrompe, pero eso es para otro momento.

Si entendemos los sistemas complejos, la antifragilidad, la parcialidad de la información y el Efecto Lindy, entonces debemos utilizar esta última herramienta para establecer un ancla que nos permita unir todo lo anterior, y nos escude parcialmente de los Cisnes Negros.

¿Cuál es el ancla que podemos usar para sobrevivir a la Vida Moderna, y en especial a la Medicina Moderna?

La mejor ancla que conocemos es la evolutiva.

Incluso el pavo se beneficiaría de esta lógica:

Evolutivamente no es normal que me alimenten a horario, no me mueva de unos pocos metros cuadrados, viva con miles de otros pavos en el mismo espacio cerrado y todas las decisiones las tome el mismo que tiene el monopolio de la fuerza; quien más encima no tiene consecuencias porque interviene sobre el resto.

De saber un poco de evolución los pavos habrían tratado de escapar hace tiempo.

(Mientras lo escribí noté el parecido con el homínido modernus)

Saltar sin Paracaídas

Como he escrito anteriormente, la evolución es un proceso de conocimiento por eliminación.

El resultado es empírico (completamente liderado por el resultado), no se planifica porque en sistemas complejos NO se puede planificar con certeza.

Este proceso de eliminación se denomina via negativa.

Es el intento de caracterizar lo infinito mediante la eliminación. Viene de la religión, y tiene un sustrato matemático fundamental.

Un sistema complejo no es predecible, por lo tanto no es modelable (no sé cuántas veces voy a reiterar este punto). Esto se traduce en que los intentos por entenderlo a cabalidad (necesario para predecir con certeza) sean inútiles.

Pero, aunque nunca podamos abarcar todo, sí podemos adquirir conocimiento.

¿Alguna vez has tratado de saltar de un quinto piso?

¿O has tratado de parar una bala con tu mano?

¿Por qué no?

Para un médico “basado en la evidencia” no hay estudios de suficiente calidad para determinar que esto es imposible.

No existe un estudio "randomizado doble ciego” que nos aclare fuera de toda duda que no debemos hacer lo que ahí describo.

Sin embargo, todos sabemos el resultado.

Mas aún, hay una frase que explica muy bien lo que ha pasado con los estudios científicos: la estadística aguanta todo.

En una jugada experta, salió hace unos años una publicación (un paper) en una prestigiosa revista que demuestra exactamente cuánto aguanta la estadística—y los sesgos—a la hora de plantear resultados “estadísticamente significativos”.

En diciembre del 2018 se publicó un estudio titulado “Parachute use to prevent death and major trauma when jumping from aircraft: randomized controlled trial” (pueden ir al estudio aquí).

En español sería algo así como: “Uso de paracaídas para prevenir la muerte o trauma mayor al saltar de un avión: estudio randomizado controlado”

En este estudio designaron al azar (randomizaron) a 23 personas en dos grupos:

En el primero las personas iban a saltar de un avión con paracaídas.

En el segundo las personas iban a saltar de un avión sin paracaídas.

Llevaron a cabo su experimento, hacerlos saltar de un avión.

La conclusión:

“Parachute use did not reduce death or major traumatic injury when jumping from aircraft in the first randomized evaluation of this intervention”.

“El uso de paracaídas no redujo las muertes o lesiones traumáticas al saltar de un avión en la primera evaluación randomizada de esta intervención”

¿Cómo puede ser?

Si efectivamente saltaron con un paracaídas debería significar que al menos algunos se salvaron de morir, y en el otro grupo deberían haber muerto todos.

¿Cómo es posible que no haya una diferencia?

Ahí es donde entra el diseño de un estudio.

El diseño es la forma específica en que se va a tratar de demostrar que cierta intervención tiene o no un resultado específico.

En este caso, el experimento se diseñó con una pequeña avioneta, y ésta estaba en el suelo, estacionada.

Los dos grupos saltaron de poco más unos 30 centímetros.

Nadie sufrió daño alguno…

Suena ridículo, lo sé.

Pero el punto que hacen es innegable: el diseño de los estudios va a determinar el resultado, y los sesgos informarán el diseño. Por lo tanto, si uno lo quiere, puede encontrar evidencia para todo.

¿Qué decir cuando te piden evidencia?

Una falacia común en la actualidad es la necesidad de los intervencionistas de pedirte que demuestres tu evidencia.

Básicamente te piden que demuestres que saltar del quinto piso es peligroso.

Y como cualquier intervención genera consecuencias después de haber ocurrido (elemental querido Watson), por definición una nueva intervención no tendrá evidencia de daño.

Por eso la lógica le gana a la evidencia.

Y el conocimiento por eliminación le gana al intervencionismo.

El intervencionista promedio olvida un detalle importante: quien quiere intervenir un sistema complejo tiene que demostrar la seguridad.

No al revés.

(Los reduccionistas tienden a llamar a esto falacia naturalista, como si la evolución fuera un gorro que se pueden sacar cuando quieren. En realidad su falacia es intervencionista/reduccionista/fragilizante)

Por ejemplo: si yo quiero demostrar que ponerle flúor al agua es mejor que no ponerle, debo demostrar fuera de toda duda que esto es seguro para quienes lo van a ingerir. Para un antifragilista es fácil encontrar el error lógico, pero juguemos…

Agregar flúor significa que debo someter a una población a un riesgo potencial, a cambio de un posible beneficio. Esto normalmente se llama análisis riesgo/beneficio, y sólo cuando el beneficio supera el riesgo uno debería intervenir.

Por lo tanto debo persuadirlos.

Primero debo explicar adecuadamente los riesgos y los beneficios (pero los riesgos no los sabemos a priori) para que la gente tome informadamente su decisión.

Luego, si no funciona o no tengo argumentos suficiente, puedo tratar de asustar a la población para que lo acepte.

Y si esto no funciona puedo simplemente forzarlo.

Con el flúor se forzó y luego se ha mantenido en base a miedo (y a desestimar los estudios que muestran el daño).

Es una trampa difícil de escapar, pero para un antifragilista usuario del conocimiento por eliminación la respuesta es simple:

—Quien quiera intervenir debe demostrar seguridad—y esto tiene una segunda parte: cualquier evidencia clara de una respuesta contraria es suficiente para descartar la intervención.

A qué me refiero…

Soy un medipavo, y logro convencer a un país entero que podemos volar, (por supuesto convenzo a los politipavos) y se instaura el Día Nacional del Salto del Quinto Piso (entretanto hago proyecciones sobre lo maravilloso que será nuestro futuro una vez que todos vean que sí podemos volar).

Llega el día del salto—que está coordinado para que todos lo hagamos al mismo tiempo—pero un “paciente” se apura y salta un minuto antes de la hora x.

Los canales de televisión lo muestran en cadena nacional mientras cae del quinto piso.

Por un segundo realmente pareciera que puede volar.

Luego se estrella contra el suelo y no se mueve más.

El silencio es absoluto.

Uno a uno toda la población se aleja del borde de los edificios.

Pero yo no me doy por vencido, y aplicando la lógica reduccionista les trato de convencer que seguramente esa persona tenía algún problema, quizás era pecador, quizás no pagaba sus impuestos, o quizás tenía un problema en el hígado (qué se yo); lo clave es que UN caso no es evidencia, es sólo una anécdota.

Lo que se conoce cono “reporte de caso” en la literatura médica.

Pero he perdido a mi público.

Me miran y con decepción se dan la vuelta mientras comienzan a bajar en silencio al mundo real. Pareciera que se convencieron a pesar de no tener evidencia suficiente.

“Estúpidos, no entienden nada de estadística, un caso no es evidencia suficiente!” Les grito mientras veo sus espaldas desaparecer en la escalera.

Me quedo gritando solo en el borde del edificio.

¿Pero, es realmente insuficiente la evidencia?

Volvamos atrás: “cualquier evidencia clara de una respuesta contraria es suficiente para descartar la intervención.”

En sistemas complejos el conocimiento sólo se puede avanzar por via negativa.

No se requiere más que una determinación suficientemente clara de que la idea está equivocada para descartarla.

Una persona reventándose contra el piso es suficiente para descartar la hipótesis que podemos volar.

¿Podemos con esto establecer cuál es el rango máximo de altura que todos vamos a sobrevivir?

No.

Por ser complejos, esto es indeterminable, pero sí podemos establecer lo que no debemos hacer.

Entonces, cuando llegue un reduccionista fragilizador a pedirte “evidencia” que agregarle flúor al agua (o cualquier intervención) es peor que el agua sola—que sólo nos ha acompañado durante toda la historia de la vida en la Tierra—tu puedes mostrarle cualquiera de los miles de estudios que muestran daño, a lo que él te dirá que son insuficientes por tal o cual razón.

De ahí en adelante lo ignoras; hay peleas que no vale la pena dar.

Puedes repetir este proceso con quien quiera convencerte que la comida ultraprocesada no hace daño; que la carne falsa es buena para tu salud; que los aceites vegetales son saludable; que tomar medicamentos es necesario; que los impuestos son moralmente defensibles; que los protocolos son indispensables; en fin…

Para sobrevivir a la Vida Moderna se requieren principios filosóficos, no evidencia.

Entender la complejidad, buscar la antifragilidad, escudarse de Cisnes Negros, y aprender mediante via negativa.

En la parte cuatro voy a explorar el problema de los incentivos, y así ayudarnos a entender cómo desarrollar un sistema que nos proteja de nosotros mismos—y de los politipavos, buropavos, medipavos y el resto de la fauna pavuna.

Veremos el Efecto Cobra.

Por ahora a descansar.

¡Hasta la próxima!

Te deseo suerte en tu camino,

Javier Richard